Libra AI

综合介绍

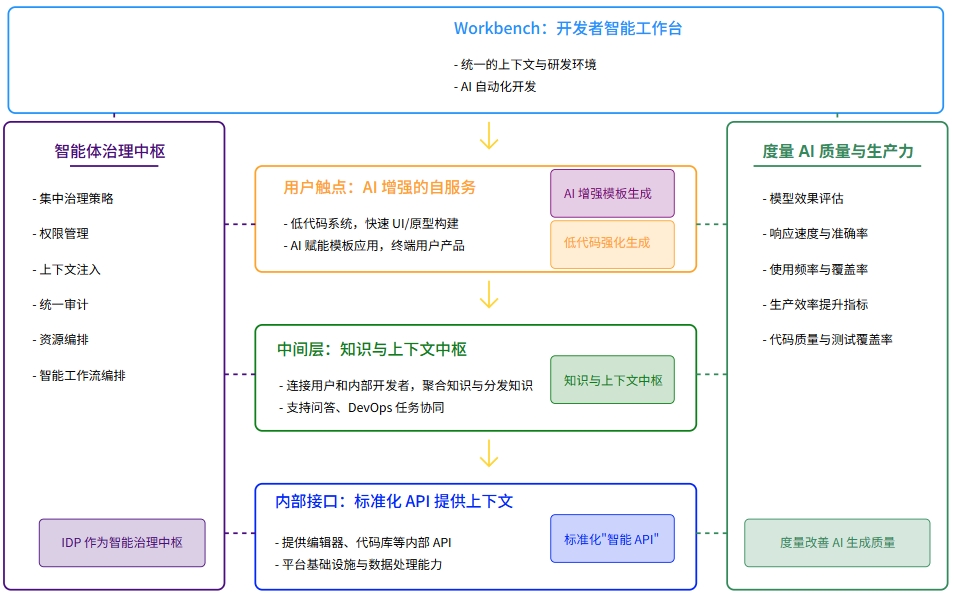

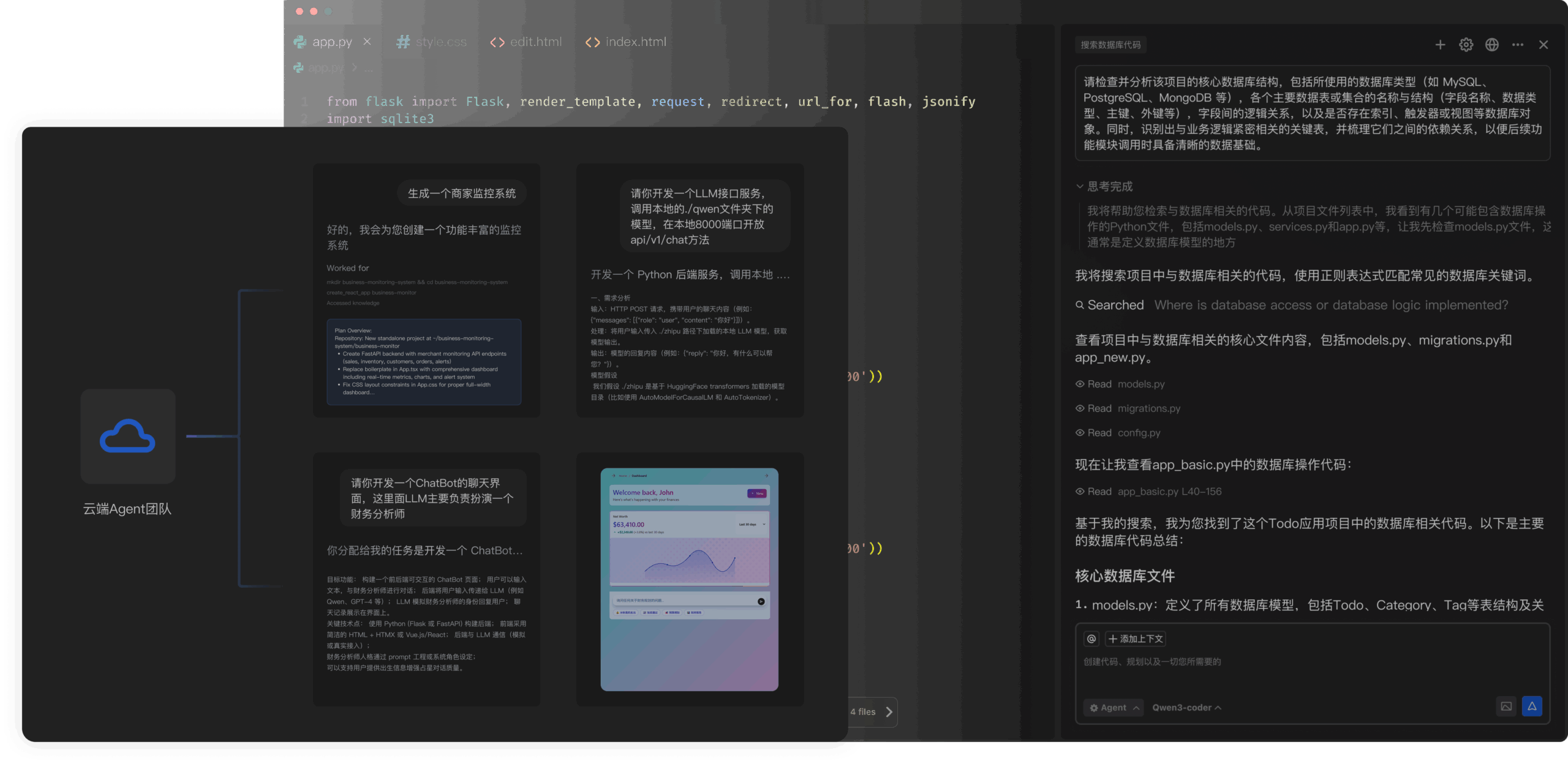

Libra AI 是一个开源的AI原生开发平台,它可以让用户通过自然语言管理Web应用从设计、开发到部署的整个过程。这个平台被设计为Vercel V0等工具的替代方案,并完全构建在Cloudflare的技术架构之上。用户可以直接用一句话描述自己的需求,Libra AI就能生成符合生产环境要求的代码,并提供完整的集成开发环境、云端预览和一键部署功能。它的核心理念是将自然语言作为一种新的应用程序开发方式,实现从想法到产品的快速迭代。该项目采用AGPL-3.0开源协议,同时也为需要闭源使用的企业提供商业授权。

功能列表

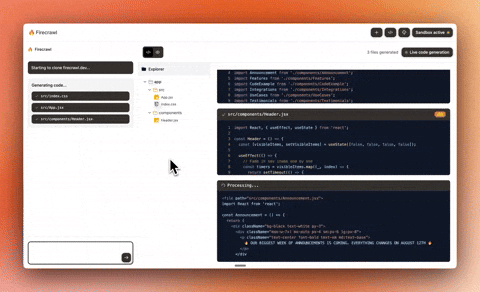

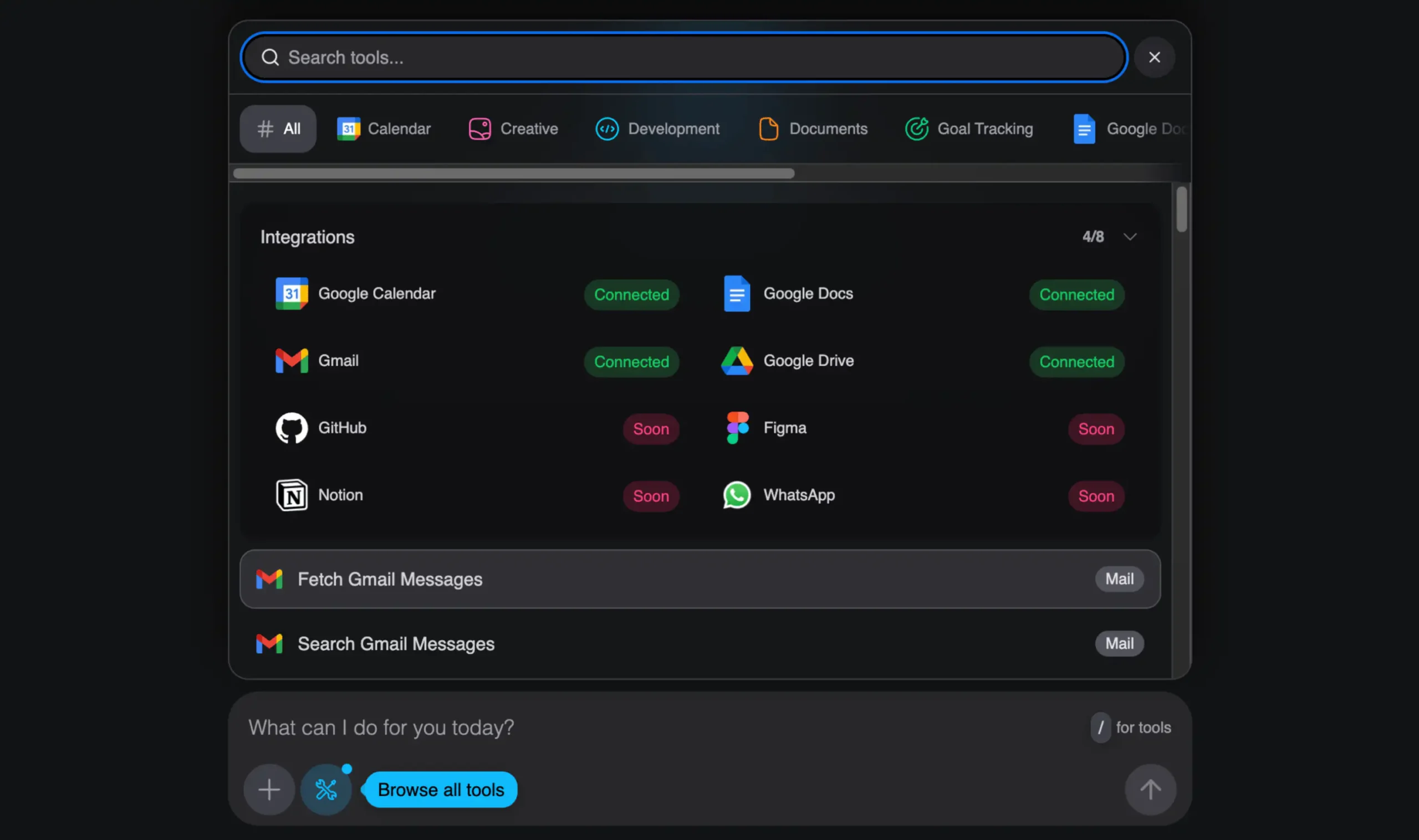

- AI驱动编码:支持集成Claude、OpenAI、Gemini等多种大语言模型,通过自然语言对话即可生成生产级别的代码。AI能够智能理解上下文,并遵循最佳实践。

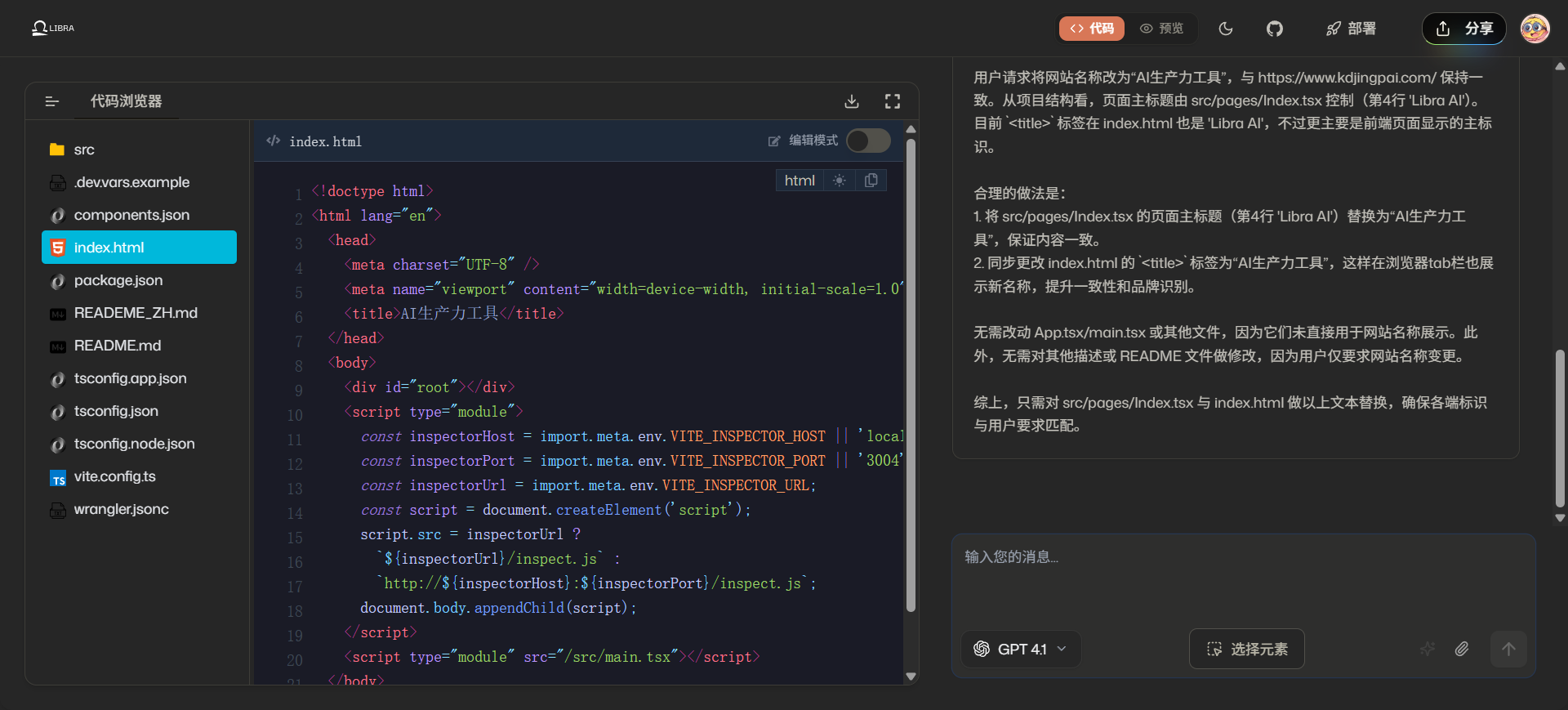

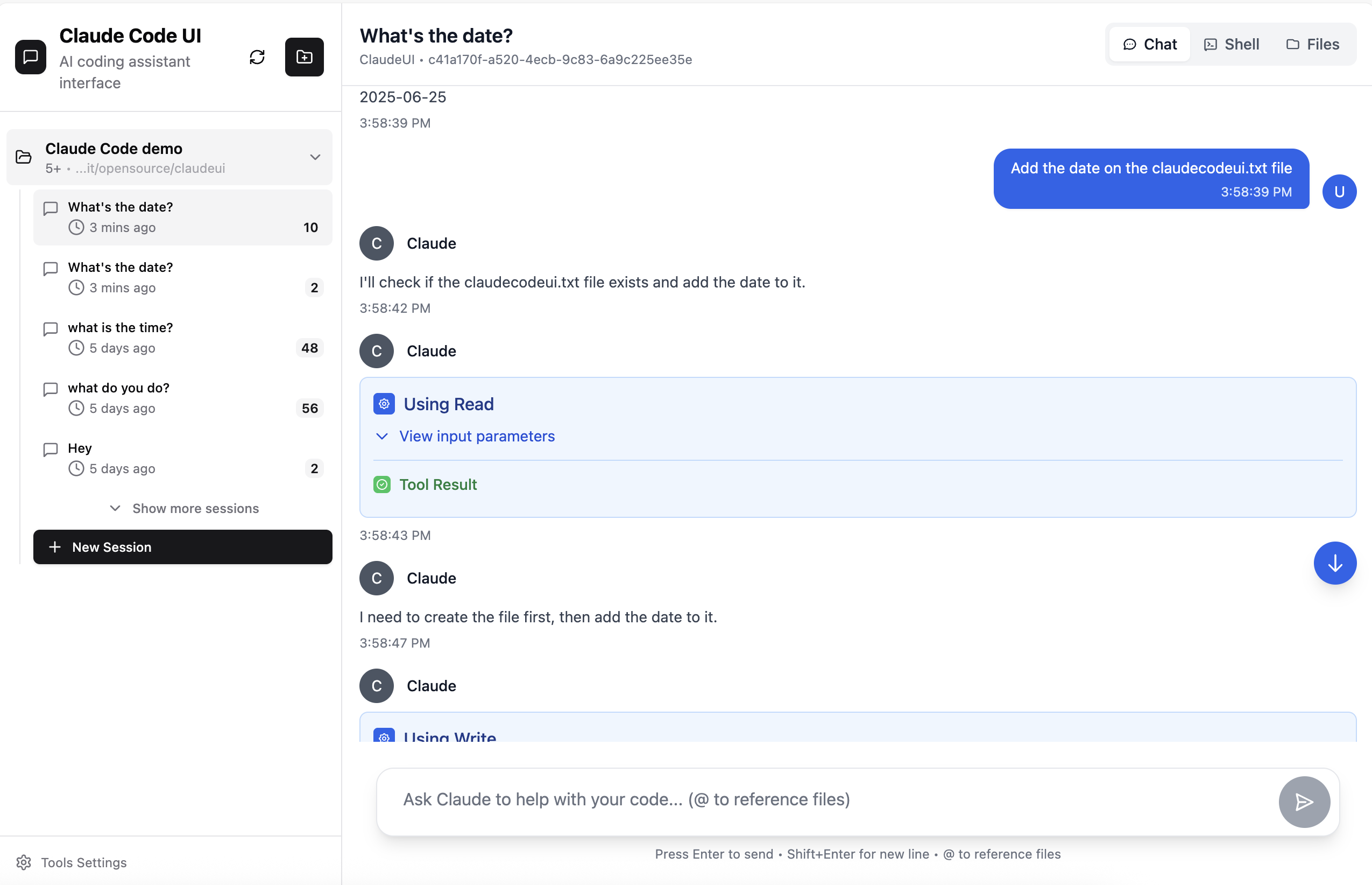

- 集成开发体验:提供云端IDE,具备语法高亮、代码缩进和实时热更新预览功能。系统能自动分析代码依赖并完成安装。

- 全栈技术整合:与GitHub深度集成,可实现代码单向同步。内置企业级的身份认证(OAuth 2.0)和Stripe商业订阅管理功能。

- 生产级部署:基于Cloudflare Workers的全球边缘计算网络进行部署,采用无服务器架构,能够弹性扩容,并自动管理TLS/SSL证书。

- 多沙箱环境支持:支持E2B和Daytona等多种代码执行沙箱,确保AI生成代码的执行过程安全隔离。

- 完整的技术自主权:作为开源项目,用户拥有完全的数据和技术控制权,可以避免供应商锁定,并进行深度定制开发。

- 数据库集成:核心业务数据库使用PostgreSQL,认证数据使用Cloudflare D1(SQLite),并通过Hyperdrive加速数据库连接。

使用帮助

Libra AI提供了两种主要的使用方式:官方提供的云托管服务和开发者在本地进行的开发部署。

一、 云托管服务(推荐)

这是最简单快捷的方式,无需任何本地配置,适合希望快速启动项目的用户。

- 访问官方网站

libra.dev。 - 使用GitHub账户或邮箱进行快速注册。

- 注册成功后,即可进入平台,通过对话式界面开始构建你的Web应用。

- 应用构建完成后,可以一键部署到自定义域名。

二、 本地开发部署(针对开发者)

如果你需要对平台进行深度定制或二次开发,可以选择在本地环境中部署。这种方式让你拥有源代码的完全控制权。

1. 环境要求

在开始之前,请确保你的系统安装了以下工具:

git: 版本需>= 2.30.0node: 版本需>= 20.0.0(推荐使用版本24)bun: 版本需>= 1.0.0

你可以通过在终端输入 git --version, node --version, 和 bun --version 来检查版本。

2. 本地环境设置流程

步骤 1: 获取源代码首先,从GitHub克隆项目代码到你的本地计算机。

git clone https://github.com/nextify-limited/libra.git

进入项目目录,并使用Bun安装所有依赖项。

cd libra

bun install

步骤 2: 配置环境变量项目根目录下有一个名为 .env.example 的环境变量示例文件。你需要复制这个文件并重命名为 .env。

cp .env.example .env

接下来,你需要用文本编辑器打开 .env 文件,并根据文件内的注释提示,填写必要的配置信息,例如数据库连接地址、AI模型的API密钥、GitHub OAuth应用信息等。这是本地运行所有服务的关键一步。

步骤 3: 初始化数据库Libra AI使用两种数据库:一个主数据库(PostgreSQL)和一个认证数据库(Cloudflare D1/SQLite)。

- 初始化主数据库 (PostgreSQL):进入

packages/db目录,生成并执行数据库迁移脚本。cd packages/db bun db:generate bun db:migrate - 初始化认证数据库 (D1/SQLite):进入

packages/auth目录,生成并执行认证数据库的迁移脚本。cd packages/auth bun db:generate bun db:migrate

步骤 4: 启动开发服务完成所有配置后,回到项目根目录,运行以下命令即可启动所有本地服务:

bun dev

如果你只想启动主应用,可以单独进入 apps/web 目录运行 bun dev。

步骤 5: 配置Stripe支付(必需)为了使商业订阅功能正常工作,你需要监听Stripe的Webhook事件。运行以下命令:

stripe listen --forward-to localhost:3000/api/auth/stripe/webhook

3. 本地服务访问地址

成功启动后,你可以在浏览器中访问以下地址来使用和管理本地部署的Libra AI平台:

- 核心应用 (web):

http://localhost:3000 - 邮件预览 (email):

http://localhost:3001 - 认证管理 (auth-studio):

http://localhost:3002 - 技术文档 (docs):

http://localhost:3003

三、 功能操作流程

无论使用云托管服务还是本地部署,核心操作流程都围绕自然语言交互展开。

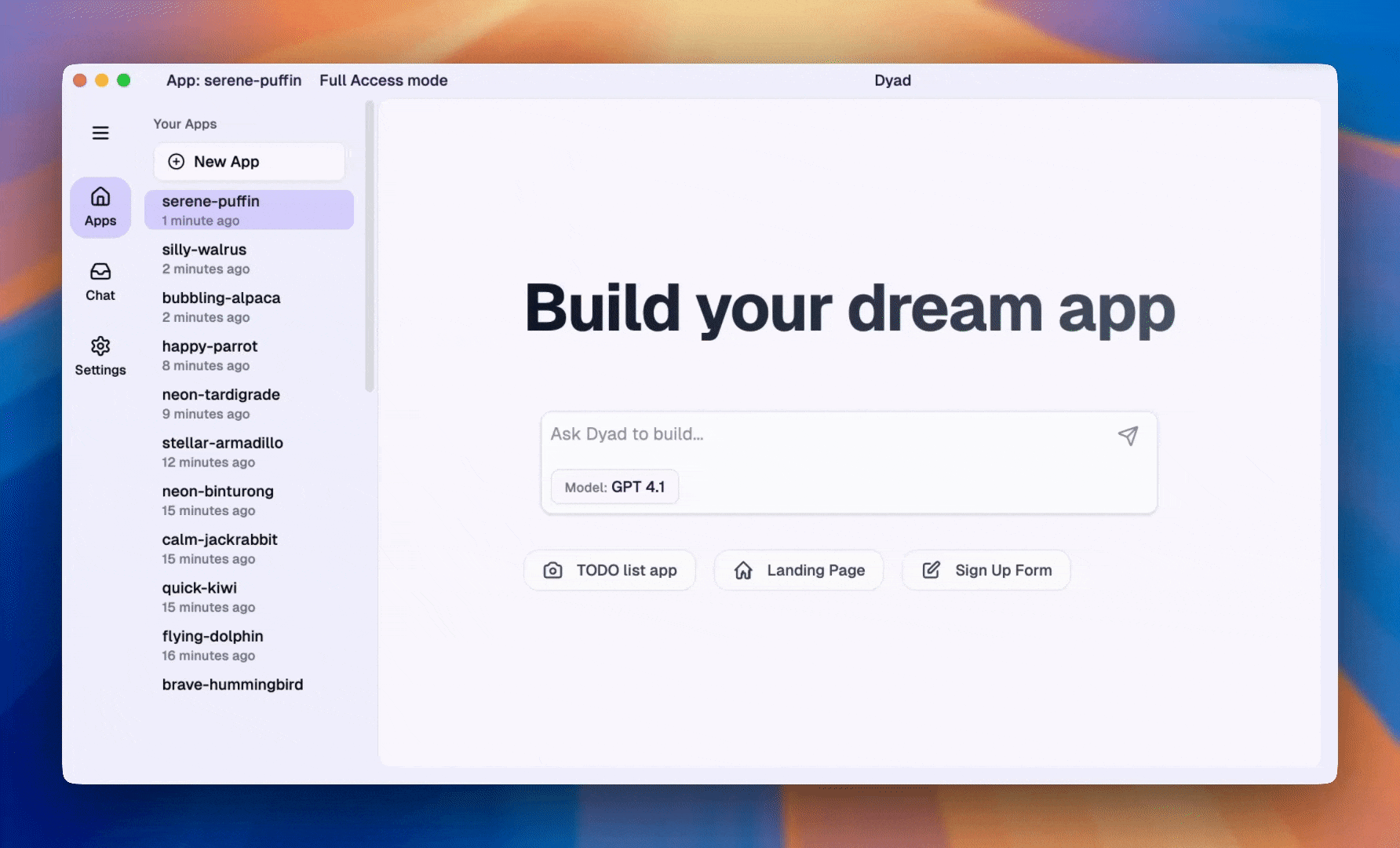

- 项目创建: 在主界面,你会看到一个输入框。在这里输入你的应用想法,例如:“创建一个可以发布博客文章的网站,需要有标题和内容输入框”。

- AI生成代码: Libra AI的后台模型会解释你的需求,并生成相应的代码,包括前端界面(使用Next.js和React)和后端逻辑。

- 实时预览与修改: 生成的代码会立即在右侧的预览窗口中展示出来。同时,你也可以在左侧的云端IDE中查看和编辑源代码。如果你想调整界面,可以直接用自然语言下达指令,比如:“把按钮的颜色改成蓝色”,或者直接在代码编辑器中修改。

- 部署: 当你对应用满意后,点击“部署”按钮。Libra AI会自动处理所有构建和部署流程,将你的应用发布到Cloudflare的全球网络上。如果你配置了自定义域名,应用将会部署到该域名。

应用场景

- 快速原型验证对于想要快速验证一个产品想法的初创公司或独立开发者,可以使用Libra AI在几分钟内生成一个可交互的应用原型,无需编写一行代码。这极大地缩短了从想法到原型的验证周期。

- 企业内部工具开发企业内部通常需要大量定制化的管理后台或工具。利用Libra AI,技术能力有限的员工也可以通过描述需求来构建这些工具,例如构建一个数据看板、一个审批流程应用或一个信息管理系统。

- Web开发教育与学习对于Web开发初学者而言,Libra AI是一个很好的学习工具。学生可以通过观察AI如何将自然语言需求转化为具体的、符合行业最佳实践的代码,来理解现代Web应用的架构和开发模式。

- 全栈项目快速启动专业的全栈开发者可以使用Libra AI来快速生成项目的基础架构,包括前后端代码、数据库模型和部署配置。这可以省去大量重复的初始化工作,让开发者更专注于核心业务逻辑的实现。

QA

- 托管平台和开源版本有什么核心区别?托管平台是官方提供的SaaS(软件即服务)版本,开箱即用,包含了所有AI功能和企业级支持。而开源版本提供了项目的核心源代码,用户需要自己进行部署、配置和维护,但拥有更高的自主性和定制能力,可以进行深度开发。

- AI生成的代码质量如何?Libra AI致力于生成生产环境可用的高质量代码。生成的代码遵循行业最佳实践,例如使用完整的TypeScript类型安全、响应式设计、无障碍组件以及清晰可维护的代码结构。

- 使用Libra AI需要什么样的技术背景?对于使用云托管平台的用户,无需任何编程背景。对于在本地部署和开发的开发者,需要具备基础的Web开发知识(了解Node.js、Git等)。如果需要进行私有化部署,则需要具备一定的服务器和DevOps运维经验。

- 这个项目可以用于商业用途吗?可以。开源版本遵循AGPL-3.0协议,要求基于它提供网络服务的衍生项目也必须开源。如果你的商业项目需要闭源,Libra AI官方也提供商业授权,允许你在闭源产品中使用该技术。